Ciencia y Sociedad, Vol. 49, No. 3, julio-septiembre, 2024 • ISSN (impreso): 0378-7680 • ISSN (en línea): 2613-8751

LA EVALUACIÓN DE LA INVESTIGACIÓN EN REPÚBLICA DOMINICANA: PERSPECTIVA DE LOS ACTORES DEL SISTEMA NACIONAL DE CIENCIA, TECNOLOGÍA E INNOVACIÓN

The evaluation of research in the Dominican Republic: the perspective of stakeholders in the National Science, Technology and Innovation System

DOI: https://doi.org/10.22206/cys.2024.v49i3.3240

Giovanna Riggio-Olivares

Universidad Iberoamericana (UNIBE)

https://orcid.org/0000-0001-9162-2646

g.riggio@unibe.edu.do

Aída Mencía-Ripley

Universidad Iberoamericana (UNIBE)

https://orcid.org/0000-0001-7510-4072

a.mencia@unibe.edu.do

Ramón I. Rosario-Díaz

Universidad Iberoamericana (UNIBE)

https://orcid.org/0009-0009-4010-2603

rosario4@est.unibe.edu.do

Recibido: 19/7/2024 • Aprobado: 22/8/2024

Cómo citar: Riggio-Olivares, G., Mencía-Ripley, A. & Rosario-Díaz, R.I. (2024). La evaluación de la investigación en República Dominicana: perspectiva de los actores del sistema nacional de ciencia, tecnología e innovación. Ciencia y Sociedad, 49(3), 33-58. https://doi.org/10.22206/cys.2024.v49i3.3240

Resumen

El Sistema Nacional de Indicadores de Ciencia y Tecnología de la República Dominicana se encuentra en una etapa avanzada de diseño y próximo a implementarse. Este sistema facilitará el monitoreo sistemático de distintas dimensiones del desempeño científico y tecnológico del país. En el marco del proyecto de investigación titulado «Estudio de línea base para la implementación del Sistema Nacional de Indicadores de Ciencia y Tecnología de la República Dominicana», se llevó a cabo un grupo focal con el propósito de evaluar las experiencias, percepciones y opiniones de diversos actores del ecosistema nacional de ciencia y tecnología sobre los indicadores cienciométricos y los procesos de evaluación de la investigación y la innovación. Los resultados ponen de relieve las valoraciones de gestores e investigadores acerca de los modelos, políticas y sistemas de evaluación vigentes, así como los métodos e instrumentos que utilizan en la práctica evaluativa. Este artículo presenta un análisis detallado de los resultados del grupo focal y sus implicaciones.

Palabras clave: evaluación de la investigación, indicadores cienciométricos, universidades, República Dominicana.

Abstract

The National System of Science and Technology Indicators of the Dominican Republic is at an advanced stage of design and will soon be implemented. This system will facilitate the systematic monitoring of different dimensions of the country's scientific and technological performance. As part of the research project entitled "Baseline Study for the Implementation of the National System of Science and Technology Indicators of the Dominican Republic", a focus group was carried out to assess the experiences, perceptions and opinions of different stakeholders of the national science and technology ecosystem on the scientometric indicators and the processes of evaluating research and innovation. The results highlight managers' and researchers' assessments of current evaluation models, policies and systems, as well as the methods and instruments they use in their evaluation practice. This article presents a detailed analysis of the focus group results and their implications.

Key words: research evaluation, scientometric indicators, universities, Dominican Republic.

Introducción

En la última década, la literatura científica sobre las prácticas de evaluación de las actividades de I+D+i y los indicadores cienciométricos ha tenido un fuerte enfoque metodológico (Glänzel et al., 2019; Daraio y Glänzel, 2020; Maltseva y Batagelj, 2020). Una revisión de trabajos recientes permite enumerar de forma resumida los temas centrales del debate mundial y regional actual sobre estos temas (de Rijcke et al., 2023; Red Iberoamericana de Indicadores de Ciencia y Tecnología, 2022; FOLEC/CLACSO, 2020a, 2020b, 2022). Entre los temas que ocupan el debate está replantearse la forma de evaluar a los investigadores, las instituciones y los resultados científicos de los países. Este cambio es necesario y urge para todos los niveles (global, regional, nacional e institucional), porque las métricas funcionan en cascada a través de todo el ecosistema de investigación y todos estos niveles están interconectados. También se priorizan la integridad y la calidad de la investigación, maximizar una ciencia diversa, inclusiva y no discriminatoria, y optimizar la ciencia para el bien público mundial son los principales motores del cambio en el contexto de un mundo en rápida transformación (de Rijcke et al., 2016, 2023).

Es necesario además disponer de sistemas de evaluación de la investigación más equilibrados, con indicadores cuantitativos y cualitativos que valoren múltiples formas de resultados, procesos y actividades de investigación. Cada vez hay más partidarios de las "métricas responsables" que se alejan de las métricas puramente cuantitativas para adoptar una variedad más amplia de medidas que permitan describir el impacto económico, social, cultural, medioambiental y político de la investigación y determinar en qué medida está relacionada la investigación científica con las necesidades de la sociedad.

La respuesta a un mundo en rápida evolución y con una creciente demanda de equidad en el acceso a la ciencia ha sido la transición a la ciencia abierta. Esto tiene implicaciones en las prácticas de evaluación de los resultados científicos, en la evolución de la revisión por pares, en la aplicación de la inteligencia artificial en procesos de evaluación, entre otras. En el ámbito internacional se promueve de forma intensa un entendimiento común de la ciencia abierta y de sus múltiples beneficios, principalmente con el fin de acelerar la producción y el uso de nuevos conocimientos y restituir o ampliar los puentes entre ciencia y ciudadanía, fundamentado en la noción del conocimiento como bien público. Según la definición de la Unesco (2021), "ciencia abierta" es un conjunto de principios y prácticas cuyo objetivo es hacer que la investigación científica de todos los campos sea accesible para todos, en beneficio de los científicos y de la sociedad en su conjunto. La ciencia abierta no solo se centra en garantizar el acceso al conocimiento científico, sino también en asegurar que la producción de ese conocimiento sea inclusiva, equitativa y sostenible.

En el contexto latinoamericano, los procedimientos de evaluación científica actualmente dominantes inciden en las agendas científicas, forzándolas hacia temáticas internacionalizadas. Los sistemas de evaluación de la investigación y de reconocimiento a los investigadores en América Latina y el Caribe (ALC) suelen favorecer una noción de excelencia anclada en las metodologías del “Norte Global”, basadas exclusivamente en el factor de impacto de las revistas y en los rankings internacionales. Ello refuerza la tendencia persistente a producir una ciencia poco aplicable y de baja relevancia que atiende a los intereses y necesidades de audiencias desconectadas de la realidad de ALC. Se requiere desarrollar metodologías de análisis basadas en indicadores que ayuden a considerar perspectivas plurales (Invernizzi, 2022).

Como consecuencia, en la última década ha surgido en todo el mundo un conjunto de declaraciones de principios, iniciativas y estudios sobre esta problemática y proponen cambios en su abordaje. Entre muchas iniciativas sobresalen las siguientes:

- Declaración de San Francisco sobre Evaluación de la Investigación (DORA, 2012), la cual desincentiva el uso de métricas basadas en revistas indizadas, como el factor de impacto de las publicaciones como medida sustitutiva de la calidad de los resultados de investigación.

- Manifiesto de Leiden (Hicks et al., 2015), que advierte sobre el uso incorrecto generalizado de los indicadores en la evaluación del desempeño científico.

- Llamada de Jussieu para la Ciencia Abierta y la Bibliodiversidad (Francia, 2016), la Iniciativa Helsinki sobre Multilingüismo en la Comunicación Científica (2019) y la Red Europea para la Evaluación en las Ciencias Sociales y Humanidades (ENRESSH), que realizan un llamado a reformular los sistemas de evaluación a fin de contemplar las distintas prácticas de comunicación científica (con atención a las ciencias sociales y humanidades), e invitan a promover la diversidad lingüística en los sistemas de evaluación y de financiación de la investigación.

- La Declaración de Barcelona sobre Información de Investigación Abierta (Barcelona Declaration on Open Research Information), una iniciativa desarrollada por un equipo internacional de especialistas en información de investigación, cuyo objetivo es democratizar el acceso a la información de investigación La propuesta busca que la información sobre investigación esté disponible de manera abierta a través de infraestructuras académicas también abiertas, con el fin de avanzar en la evaluación responsable de la investigación y la ciencia abierta, y promover la toma de decisiones imparcial y de alta calidad.

- El consorcio Research on Research Institute (RoRI) (Reino Unido), que asume una posición crítica frente a los sistemas de evaluación vigentes en el debate internacional, centrados en la implementación errónea de indicadores limitantes de la calidad o impacto de la investigación a través de criterios cuantificables de las trayectorias y de las instituciones.

- El Foro Latinoamericano sobre Evaluación Científica (FOLEC), que surgió en el 2019 como un espacio regional de debate e intercambio sobre los sentidos, las políticas y las prácticas de los procesos de evaluación del quehacer científico en la región, a fin de generar propuestas desde América Latina y el Caribe, en diálogo con las tendencias y buenas prácticas internacionales.

- A nivel multilateral, la Recomendación de la UNESCO sobre la Ciencia Abierta (UNESCO, 2021) hace hincapié en la necesidad de transformar la forma en que se evalúa a los investigadores y a los resultados de la investigación, e invita a consensuar y promover la implementación de políticas y prácticas en torno a este tema.

- La Comisión Europea presentó el informe Reforming research assessment: the way forward (European Commission, 2021), que prioriza la reforma de la evaluación de la investigación para garantizar la calidad, el rendimiento y el impacto de la investigación.

- Además, algunos consejos y organismos de ciencia, tecnología e innovación e instituciones de educación superior en distintos países ya han examinado sus políticas de evaluación de la investigación y adoptado una variedad de reformas.

La República Dominicana está en proceso de implementar su Sistema Nacional de Indicadores de Ciencia y Tecnología. Este sistema, ofrecerá la facilidad de conocer sistemática y periódicamente distintas dimensiones del desempeño científico y tecnológico del país, constituyendo un excelente instrumento para operar sobre esa realidad, hacer cambios oportunos y actuar sobre aspectos susceptibles de mejora. Se espera que la disponibilidad de estos indicadores promueva un mayor avance y una mayor calidad y visibilidad de la investigación que se lleva a cabo en la República Dominicana.

El imperativo de poner en marcha el Sistema Nacional de Indicadores de Ciencia y Tecnología de la República Dominicana es claro y urgente. A pesar del importante avance que supone contar con indicadores nacionales de ciencia, tecnología e innovación con objetivos evaluativos, existen limitaciones que han dificultado su implementación.

Como en muchos países, uno de los principales desafíos ha sido contar con un sistema de información que proporcione datos de calidad sobre la actividad y el desempeño científico y tecnológico. Esto incluye tanto a las instituciones de educación superior (IES) de manera individual como al Sistema Dominicano de Educación Superior, Ciencia y Tecnología en su conjunto, así como a otros sectores institucionales y productivos del país. La necesidad de fortalecer la capacidad para gestionar estos datos, mediante una adecuada articulación y coordinación interinstitucional e intersectorial, ha sido consistentemente destacada en los principales diagnósticos, estrategias y planes nacionales dirigidos a promover la I+D+i en la República Dominicana.

A nivel institucional, muy pocas universidades dominicanas han implementado un sistema de información científica basado en métodos y estándares internacionales. Además, el limitado acceso a fuentes de datos internacionales especializadas para realizar análisis bibliométricos de la producción científica constituye un obstáculo. Tampoco se ha desarrollado una base de datos nacional que compile la producción científica del país, la cual actualmente se encuentra dispersa.

El proyecto de investigación «Estudio de línea base para la implementación del Sistema Nacional de Indicadores de Ciencia y Tecnología de la República Dominicana» aborda estas necesidades. Como parte de las actividades de este proyecto, el equipo llevó a cabo un grupo focal con el objetivo de evaluar las experiencias, percepciones y opiniones de diversos actores del ecosistema nacional de ciencia y tecnología respecto a los indicadores cienciométricos y los procesos de evaluación de la investigación y la innovación. En este trabajo se analizan los resultados de dicho grupo focal.

Metodología

El grupo focal se condujo el 30 de abril de 2024. Participaron 25 personas representantes de 16 instituciones de educación superior (IES) de la República Dominicana: 12 tienen funciones de gestión de la investigación en esas IES y 13 trabajan como investigadores.

Se empleó una técnica mixta: el grupo focal como método de investigación cualitativa y la aplicación de un cuestionario que facilitó la recopilación de datos para el análisis cuantitativo. Los temas seleccionados para la reflexión individual y discusión grupal se organizaron en dos grandes dimensiones: 1) políticas e instrumentos de gestión; 2) práctica de la evaluación. De ambas dimensiones se definieron categorías temáticas para la organización y análisis de los resultados, como se muestra de forma esquemática en la Tabla 1.

Tabla 1

Dimensiones y categorías del análisis temático

Dimensiones |

Categorías |

1. Modelos, políticas y sistemas de evaluación |

– Grado de sistematización – Objetivos de la evaluación – Valoración de la calidad – Valoración del impacto – Importancia de la colaboración científica – Perspectiva de la ciencia abierta – Perspectiva de la diversidad e inclusión – Sesgos y malas prácticas de evaluación – Disposición al cambio |

2. Práctica de la evaluación |

– Métodos cienciométricos – Instrumentos – Fuentes de datos – Métricas de producción científica – Medición de la calidad científica – Medición del impacto social – Medidas de capacidad científica – Medidas de capacidad competitiva – Medidas de capacidad de innovación |

Fuente: Elaboración propia basada en el diseño metodológico de esta investigación.

Resultados

En esta sección se describen los resultados del análisis, organizados según las dimensiones y categorías temáticas previamente definidas. Las tablas y gráficos con los datos analizados se incluyen al final del artículo como anexo.

Modelos, políticas y sistemas de evaluación de la investigación

La evaluación de la investigación

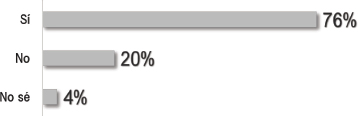

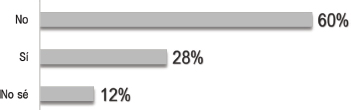

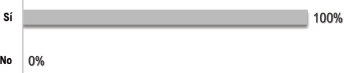

Aunque el 76% de los participantes (67% de los gestores) afirmó que en su organización se evalúan las actividades y resultados de investigación e innovación, más de la mitad señaló que esta evaluación no se realiza de manera planificada, con objetivos claros, frecuencia determinada o procedimientos definidos (Figura 1). Los participantes del grupo asignaron una puntuación promedia de 2.7, en una escala de 0 a 5, al grado de sistematización del proceso de evaluación de la investigación en sus organizaciones. En general, las instituciones dominicanas no emplean una metodología consistente y adecuada para construir indicadores cienciométricos; y muy pocas implementan un sistema de información como fuente de datos para este proceso.

Figura 1

Sistematización de los procesos de evaluación de la investigación en las instituciones dominicanas

Fuente: Elaboración propia basada en los resultados de la investigación.

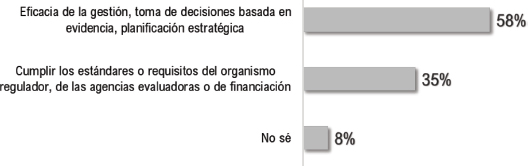

Objetivos de la evaluación

Los participantes del grupo asignaron una puntuación media de 4.5, en una escala de 0 a 5, a la importancia de construir sistemáticamente indicadores cienciométricos con fines evaluativos. La mayoría (72%) considera fundamental que las instituciones demuestren a la sociedad el rendimiento y el impacto de su investigación, principalmente como un medio para obtener reconocimiento y financiamiento para sus proyectos. La evaluación de la investigación se realiza principalmente durante la planificación estratégica institucional y, ocasionalmente, para cumplir con los requisitos de organismos reguladores, evaluadores o agencias de financiamiento.

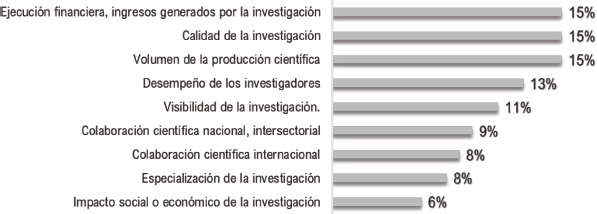

Qué se evalúa

En los procesos de monitoreo y evaluación de la investigación se analizan principalmente tres aspectos: la ejecución financiera de los proyectos, el volumen de la producción científica y la calidad de la investigación. Sin embargo, se presta muy poca atención a temas cruciales como el impacto social o el grado de especialización de la investigación. Además, la evaluación de los patrones de colaboración científica local o internacional tampoco se considera muy relevante.

Aspectos que se valoran al evaluar la calidad de la investigación

Los participantes evaluaron varios aspectos, considerando su relevancia o idoneidad como indicadores de calidad en la investigación. En una escala del 0 al 5, asignaron las puntuaciones más altas al rigor del método científico (4.8), la ética en la investigación o comunicación científica (4.7) y la revisión por pares (4.7). Sin embargo, muchos también consideran que el número de citas recibidas por las publicaciones (58%) y el factor de impacto o cuartil de la revista donde se publican los trabajos científicos (40%) confirman la calidad de la investigación. Además, en gran medida, los participantes opinaron que la calidad de la investigación se relaciona y puede medirse a través de su impacto social (56%) o de los efectos demostrables que se derivan de ella (64%).

Durante las discusiones, algunos participantes sugirieron otros indicadores de calidad, como el Índice h de los investigadores, la investigación en colaboración internacional y aquellas que propician la transferencia de conocimiento y tecnología vinculando la universidad y la empresa. Uno de los participantes relacionó la calidad con la publicación en acceso abierto, lo cual es notable ya que, contrario a esta percepción, existe un prejuicio generalizado de que las revistas de acceso abierto son de baja calidad. Otros expresaron que la calidad es un concepto relativo que debe definirse según el interés de investigación de cada universidad, considerando las diferencias entre áreas y tipos de investigación.

Reconocimiento a la calidad investigadora

Se debatió sobre la pertinencia de utilizar el número o la proporción de investigadores miembros de la Carrera Nacional de Investigadores en Ciencia y Tecnología (CNI-MESCYT) como una medida de reconocimiento a la calidad de la actividad investigadora de las instituciones. En una escala de 0 a 5, el grupo de participantes asignó una puntuación de 3.2, expresando estar moderadamente de acuerdo con este criterio. El 15% de los investigadores manifestó un completo desacuerdo, indicando poca confianza en la implementación de la Carrera. Cabe destacar que la CNI-MESCYT es una iniciativa joven cuyos efectos aún no se perciben en el sistema.

Medidas de la capacidad científica y competitiva de las instituciones

Existe un amplio desacuerdo respecto a considerar que el número o la proporción de proyectos aprobados con financiamiento del FONDOCYT sea un indicador adecuado de la capacidad científica y la competitividad de las instituciones en el ámbito de la ciencia y la tecnología. Este desacuerdo es notable entre los gestores, quienes le asignaron un puntaje de 2.2 en una escala de 0 a 5. Argumentaron que las instituciones tienen escasas oportunidades para acceder a estos fondos y señalaron, al igual que la CNI-MESCYT, poca confianza con el sistema nacional.

Aspectos valorados al evaluar el impacto de la investigación

Los integrantes del grupo focal también analizaron diversos elementos, valorando su pertinencia como indicadores del impacto de la investigación. En una escala de 0 a 5, asignaron las puntuaciones más altas a los efectos demostrables de la investigación, como el desarrollo de vacunas y de otras tecnologías (4.7); el impacto social o económico de la investigación (4.5); y la influencia en políticas públicas (4.4). El número de citas que reciben las publicaciones, un controvertido indicador que durante mucho tiempo se ha empleado como medida cuantitativa del impacto de las investigaciones, también obtuvo una alta calificación (4.2). Por el contrario, las menciones que reciben las publicaciones en redes sociales académicas, un nuevo y controvertido indicador de impacto de la investigación en la sociedad, obtuvo una puntuación media (3.4); los investigadores otorgaron más valor a este indicador que los gestores.

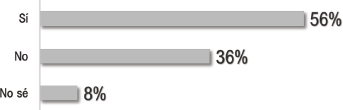

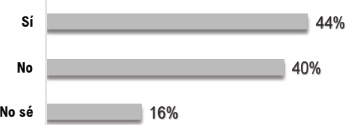

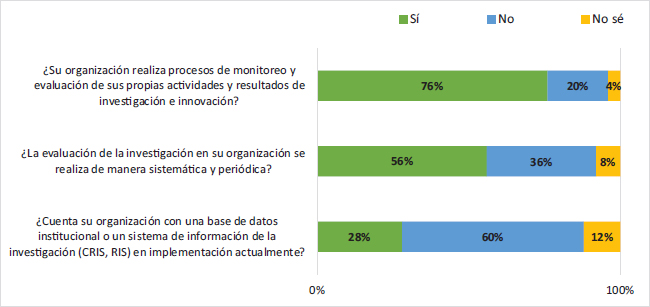

Opiniones sobre la ciencia abierta

En el ámbito de la ciencia abierta, se abordaron preguntas específicas relacionadas con la definición de políticas, la publicación en acceso abierto y los datos abiertos. No se discutieron otros aspectos, como la revisión por pares abierta, las metodologías de investigación abiertas y la ciencia ciudadana. Cerca de la mitad (44%) de los participantes afirmó que su organización cuenta con una política explícita de ciencia abierta y ejecuta estrategias para contribuir al acceso abierto a la producción científica. La gran mayoría (96%) considera que la publicación de artículos científicos en acceso abierto es muy importante. Sin embargo, solo el 72% de los participantes considera beneficioso y está totalmente de acuerdo en compartir abiertamente los datos de su investigación y permitir su reutilización por parte de otros investigadores fuera de su institución (Figura 2).

Figura 2

Opiniones sobre ciencia abierta

Fuente: Elaboración propia basada en los resultados de la investigación.

Nota: Valoraciones en una escala de 0 a 5, donde 0 es nada importante y 5 es muy importante.

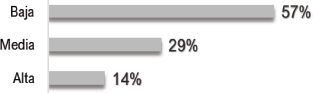

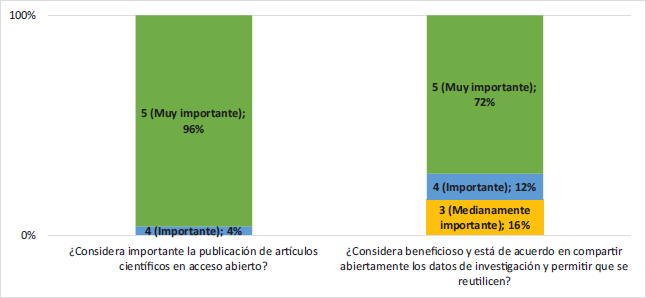

Opiniones sobre el enfoque de género en la evaluación de la investigación

Más de la mitad de los participantes (56%) opinó que no es muy importante integrar el enfoque de género en los procesos de evaluación del desempeño del personal investigador. Un 12% incluso considera que no debe integrarse esta perspectiva (Figura 3). El grupo asignó una puntuación promedio de 3.6 sobre 5, indicando que consideran moderadamente importante integrar el enfoque de género en los procesos de evaluación del desempeño del personal investigador. Asimismo, dieron una puntuación de 3.5, señalando que consideran la dimensión de género como moderadamente importante para la calidad de la investigación.

Figura 3

Opiniones sobre el enfoque de género en la evaluación de la investigación

Fuente: Elaboración propia basada en los resultados de la investigación.

Nota: Valoraciones en una escala de 0 a 5, donde 0 es nada importante y 5 es muy importante.

Práctica de la evaluación

En esta sección, examinamos las respuestas de los participantes para conocer los métodos e instrumentos empleados en la medición y evaluación del desempeño científico tanto de las instituciones como de los investigadores. También buscamos identificar posibles discrepancias entre lo que se declara que se evalúa y lo que realmente se lleva a cabo en la práctica evaluativa.

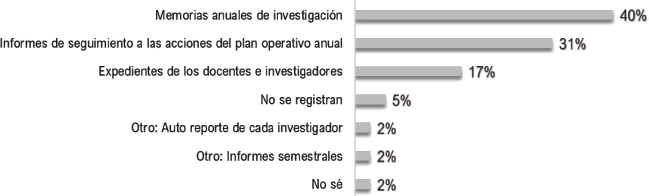

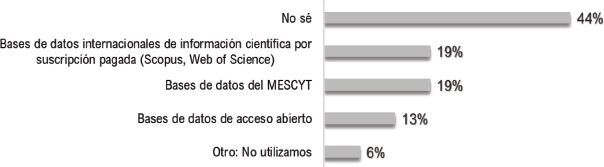

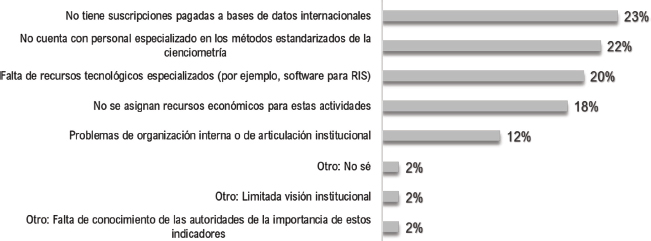

Cuáles métodos e instrumentos se utilizan

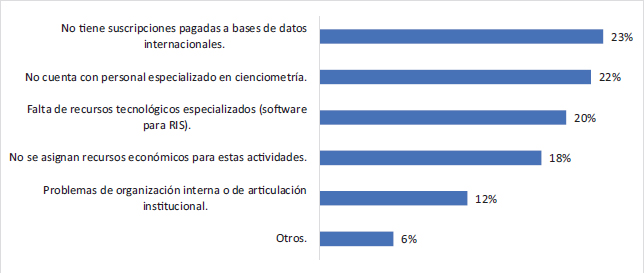

La mayoría de los participantes del grupo focal expresaron su falta de conocimiento acerca de métodos reconocidos para llevar a cabo análisis cienciométricos. Muchos identificaron la escasez de personal capacitado para realizar este proceso como un desafío significativo en sus instituciones (Figura 4). Específicamente, muchos manifestaron desconocer qué fuentes de datos deberían utilizarse o evitarse para medir y comparar el desempeño científico de instituciones y países. Sin embargo, algunos coincidieron en la importancia de evitar el uso de bases de datos institucionales que recopilen datos no depurados o normalizados. También hubo desaprobación hacia el uso de bases de datos que incluyen publicaciones en revistas de calidad cuestionable. Un participante expresó su oposición al uso de fuentes de datos no reconocidas en Europa o Norteamérica. Además, una de las principales limitaciones que los participantes destacaron para implementar un sistema de indicadores fue la falta de suscripciones institucionales a bases de datos internacionales comerciales como Scopus (Elsevier) y Web of Science (Clarivate) (Figura 4).

Figura 4

¿Cuáles son las principales limitaciones o desafíos para implementar un sistema de indicadores?

Fuente: Elaboración propia basada en los resultados de la investigación.

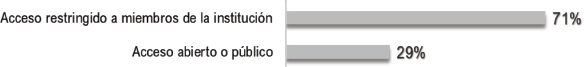

Fuentes de datos y sistemas de información

Solo el 28% de los participantes afirmó que su institución implementa un sistema de información especializado para registrar datos de actividades y productos de investigación e innovación y generar indicadores cienciométricos. La mayoría indicó que en sus instituciones los datos se recopilan de manera rudimentaria en sistemas con acceso restringido a algunos gestores, con una cobertura baja que incluye menos del 30% de los datos de actividad investigadora. Solamente dos universidades cuentan con un sistema de información de la investigación (Research Information System, RIS) que tiene una amplia cobertura de datos y es accesible públicamente en Internet. Los datos sobre actividades y productos de investigación están dispersos en las memorias anuales de investigación o en informes de seguimiento de planes operativos anuales. La mitad de los participantes dijo que no conoce ni utiliza fuentes de datos externas para generar indicadores. Solo tres instituciones dominicanas mantienen una suscripción pagada a Scopus, mientras que ninguna tiene suscripción a la Web of Science.

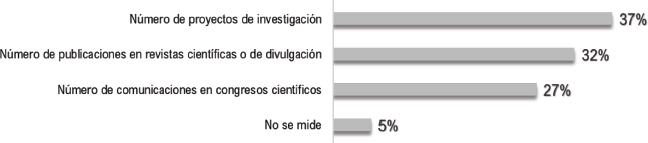

Cómo se mide el volumen de la investigación

Según el 37% de los participantes, el indicador más utilizado para medir y evaluar el volumen de la actividad científica en las instituciones es el número de proyectos de investigación; más que el número de publicaciones que surgen de esos proyectos (32%). Esto sugiere que algunas instituciones no ejercen una presión significativa sobre los investigadores para que publiquen. Puede además sugerir otras barreras para acceder el sistema de publicaciones, especialmente considerando la preponderancia del idioma inglés en las revistas de alto impacto. Una proporción menor (27%) toma en cuenta el número de comunicaciones en congresos científicos como medida de producción científica.

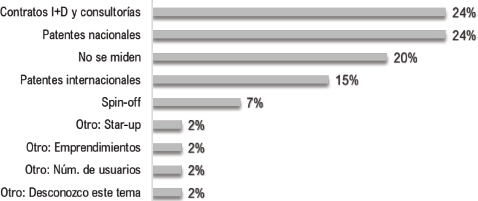

Cómo se evalúa el desempeño en innovación

El 20% de los participantes indicó que en sus instituciones no se evalúan los resultados de las actividades de innovación tecnológica, fundamentalmente porque en estas no se implementan proyectos de este tipo de forma regular. En aquellas donde sí se realiza esta evaluación, los contratos de I+D, las consultorías y las patentes nacionales son los principales productos considerados. Parece que se da menos importancia a las patentes registradas en bases de datos internacionales como productos de innovación tecnológica: solo el 15% emplea este indicador.

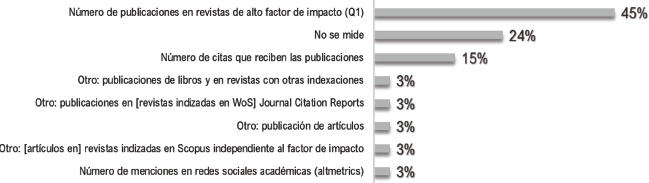

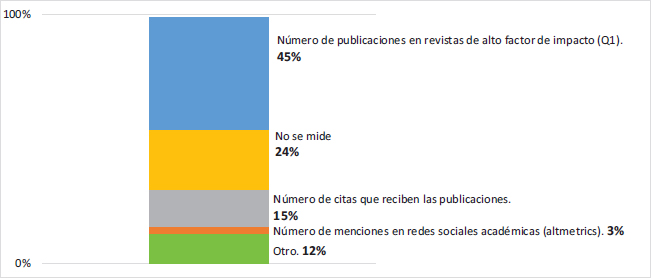

Cómo se mide la calidad de la investigación

Una considerable proporción de los participantes (24%) indicó que la calidad no es una dimensión que se evalúa, y que sus instituciones se enfocan más en monitorear el incremento del volumen de la producción científica. En las instituciones dominicanas, todavía prevalece la práctica tradicional de medir la calidad de la investigación mediante el número de publicaciones en revistas de alto factor de impacto (Q1): el 45% de los participantes afirmó que este es el indicador más utilizado en sus instituciones (Figura 5). Aunque esta práctica es muy común, tanto gestores como investigadores opinan que otros aspectos son más importantes para evaluar la calidad de la investigación, tales como el rigor metodológico, la ética en la investigación, la comunicación científica y la revisión por pares.

Figura 5

¿Cómo se mide la calidad de la investigación que se lleva a cabo en su organización?

Fuente: Elaboración propia basada en los resultados de la investigación.

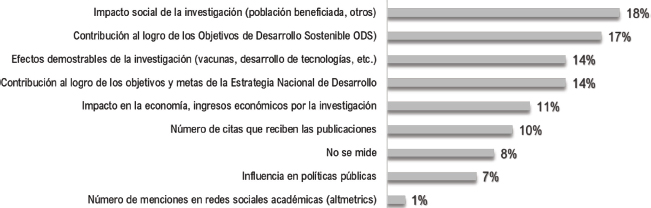

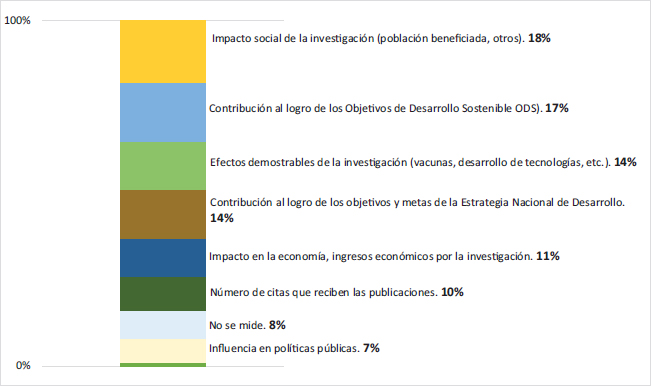

Cómo se mide el impacto de la investigación

Según los participantes, los principales indicadores utilizados en las instituciones dominicanas para evaluar el impacto de la investigación son los siguientes: impacto social, medido por el número de personas beneficiadas (18%); contribución de los proyectos a los Objetivos de Desarrollo Sostenible (17%); efectos tangibles de la investigación, como vacunas o desarrollo de tecnologías (14%); contribución a los objetivos y metas de la Estrategia Nacional de Desarrollo (14%); e impacto en la economía o los ingresos generados por la investigación (11%). La influencia de la investigación en las políticas públicas es escasamente considerada como indicador de impacto (7%). Además, muy pocos participantes afirmaron emplear el número de citas que reciben las publicaciones como medida de impacto, y apenas se utilizan las altmetrics para evaluar el impacto social de la investigación (1%). El 8% declaró que en su organización no se realiza evaluación de impacto (Figura 6).

Figura 6

¿Cómo se mide el impacto de la investigación que se lleva a cabo en su organización?

Fuente: Elaboración propia basada en los resultados de la investigación.

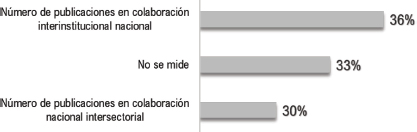

Cómo se valora y mide la colaboración científica interinstitucional

Los resultados revelaron la baja prioridad que las instituciones dominicanas otorgan a la colaboración científica interinstitucional e intersectorial a nivel nacional: el 33% de los participantes afirmó que en sus organizaciones no se mide ni evalúa este tipo de colaboración. Aquellas instituciones que sí la evalúan utilizan como indicadores el número de publicaciones en colaboración interinstitucional nacional (36%) y el número de publicaciones en colaboración nacional intersectorial (30%).

La evaluación de la colaboración científica internacional es aún más escasa en las instituciones dominicanas. Un 48% afirmó que no se mide este tipo de colaboración. Aquellos que sí la evalúan utilizan como indicador el número de publicaciones en colaboración internacional. Sin embargo, el grupo reconoció ampliamente la importancia de que los investigadores de instituciones de República Dominicana lideren grupos internacionales de investigación, asignando una puntuación media de 4.2 en una escala de importancia de 0 a 5.

Cómo se puede medir y evaluar el impacto social de la investigación

Durante el grupo focal se planteó a los participantes el reto de proponer métodos para operacionalizar la evaluación del impacto social de la investigación. Aunque muchos reconocieron la dificultad de esta tarea, algunos elaboraron propuestas que se detallan a continuación.

- No sé, es difícil operacionalizar, habría que definir indicadores medibles, estandarizados.

- Deben diseñarse procedimientos.

- El Ministerio de Educación Superior, Ciencia y Tecnología (MESCYT) debe definir indicadores cualitativos y cuantitativos de impacto social.

- En los informes de cierre de proyectos.

- Evidencias de implementaciones de soluciones a problemas sociales.

- Identificando los actores sociales (públicos o privados) beneficiarios de los resultados de investigación de los proyectos. Número de beneficiarios.

- En función de los Objetivos de Desarrollo Sostenible.

- Tomar en cuenta que en algunas investigaciones el impacto social no se puede medir en un corto plazo.

- No solo lo cuantificable; reportar, por ejemplo, transformaciones actitudinales.

- Mejoras en la calidad de vida de las comunidades.

- Relacionando el monto de la financiación del proyecto [la inversión] con su incidencia en políticas públicas, nacionales o sectoriales.

- En función de los retos de desarrollo, en el ámbito nacional o regional.

- Mediante acciones de transferencia del conocimiento generado por la investigación (seminarios, formación avanzada de postgrado, propiedad intelectual).

- Mediante indicadores de inversión extranjera.

Sobre sesgos y malas prácticas en la evaluación de la ciencia

Durante el grupo focal se debatió ampliamente el tema de los sesgos, errores o malas prácticas en los procesos de evaluación de la investigación. A continuación, se resumen los principales aspectos identificados por los participantes.

- Falta de transparencia de políticas y procedimientos de evaluación.

- Errores metodológicos, débil definición de los indicadores.

- Sobrevaloración de las publicaciones en revistas de primer cuartil (Q1).

- Infravaloración de las publicaciones en revistas nacionales o locales.

- Recopilación manual de los datos.

- Inclinación por una determinada corriente de pensamiento en el ámbito de la ciencia.

- Juicios y valoraciones subjetivas de los evaluadores.

- Prejuicios de cualquier tipo.

- No utilizar indicadores contextuales o relativos, no considerar las diferencias de los distintos campos de investigación.

- No emplear indicadores cualitativos para medir la calidad y el impacto.

- Priorizar el volumen sobre la calidad.

- No tomar en cuenta el financiamiento.

- Emplear los mismos criterios de los rankings internacionales.

- Evaluadores no expertos o poco especializados.

- Evaluadores internos (de la misma institución).

- Sesgos de dependencia (pensar que las prioridades del regulador se corresponden con las de las instituciones o de los investigadores.

- Sesgos de simetría (entre investigadores de muy alto nivel y pares de nivel inferior y viceversa).

- Visión de corto plazo sobre los proyectos de investigación por parte del regulador (se debe incorporar el principio de latencia).

- Ausencia de un enfoque de continuidad de líneas y programas de investigación.

Disposición al cambio: algunas propuestas

Existe una clara disposición y un fuerte deseo de cambio por parte de gestores e investigadores: todos los participantes estuvieron de acuerdo en la necesidad de promover y efectuar cambios en la manera en que se evalúa el desempeño y el impacto de la ciencia y la tecnología en su organización, así como en el ecosistema nacional y global de la ciencia y la innovación. A continuación, se presenta un resumen de las opiniones de los participantes sobre los cambios significativos necesarios en la medición y evaluación de la calidad y el impacto de la investigación.

- Contar con un sistema nacional de indicadores con datos públicos y dinámicos, obtenidos de fuentes externas (y no auto reportados por las instituciones).

- Sistemas de evaluación y categorización de los investigadores transparentes y a prueba de influencias o recomendaciones personales.

- Evaluaciones que se orienten a promover el avance de los investigadores y de las instituciones.

- Contar con una base de datos nacional de acceso abierto que abarque toda la producción científica y tecnológica del país.

- Que se evalúe el impacto social de las investigaciones, en el desarrollo humano.

- Que se evalúe de forma diferenciada la investigación según las áreas del conocimiento.

- Métodos e instrumentos estandarizados, qué las evaluaciones se hagan de forma sistemática.

- Mayor foco en el rigor científico.

- Considerar métricas alternativas.

- Procesos transparentes, por pares expertos.

- Combinar indicadores cualitativos y cuantitativos.

- Establecer indicadores medibles y comparables.

- No enfocarse únicamente a la investigación básica y experimental.

- Más foco en la construcción de capacidades, la formación de doctores.

- Más valor a los artículos publicados en revistas de alto factor de impacto y a los indicadores basados en recuentos de citas.

- Más atención a la proyección internacional de los investigadores nacionales.

- Más atención al financiamiento internacional de los proyectos.

- Más valor a la colaboración con entidades internacionales de prestigio.

Discusión

En esta sección se enumeran los principales hallazgos de este estudio, destacando los aspectos más relevantes del análisis, su importancia e implicaciones.

- Sistemas de evaluación. En más de la mitad de las instituciones se evalúa la actividad investigadora, pero estas evaluaciones no suelen ser planificadas ni sistemáticas. Las instituciones no emplean metodologías consistentes para construir indicadores cienciométricos. Los aspectos evaluados son principalmente la ejecución financiera de los proyectos y el volumen de la actividad científica. Se presta poca atención al impacto social y a la especialización de la investigación. Es crucial que la evaluación de la investigación se realice de manera sistemática para garantizar la objetividad, la consistencia y la adopción de modelos de métricas responsables que permitan medir la ciencia y la investigación más allá del volumen de publicaciones y de citas (Rovelli, 2023), especialmente si se busca avanzar hacia la implementación de un sistema nacional de indicadores.

- Métodos e instrumentos. Se tienen pocos conocimientos sobre métodos especializados para realizar análisis cienciométrico y las instituciones enfrentan desafíos por la falta de personal capacitado para implementar estos análisis. Muy pocas instituciones disponen de un sistema de información para registrar datos de investigación y generar indicadores cienciométricos. Únicamente dos universidades en la República Dominicana utilizan un sistema de información de investigación (RIS) accesible públicamente. La mitad de los participantes indicó que no conoce ni utiliza fuentes de datos externas para generar indicadores, y la falta de suscripciones institucionales a bases de datos internacionales se considera una de las principales limitaciones para la implementación de un sistema de indicadores. Esto afecta la capacidad de medir de manera efectiva el desempeño y el impacto de la investigación. También dificulta la transparencia y la eficiencia en la gestión de la investigación, así como la rendición de cuentas hacia los financiadores y la sociedad en general (Sivertsen, 2019). Abordar estos desafíos es fundamental para mejorar la infraestructura científica y tecnológica de las instituciones dominicanas.

- Evaluación de la calidad. La calidad no siempre se evalúa, y aunque la mayoría opina que lo que define la calidad es el rigor del método científico, la ética en la investigación y la revisión por pares expertos, la práctica que prevalece es la medición mediante el número de publicaciones en revistas de alto impacto (Q1). Esto pone de relieve cómo las métricas cuantitativas pueden influir en los incentivos académicos y el reconocimiento, promoviendo una cultura donde la cantidad de publicaciones puede priorizarse sobre la profundidad y la calidad en la investigación. Se destaca la necesidad de un debate continuo sobre cómo medir y promover la verdadera calidad en la investigación, más allá de las métricas tradicionales, para fomentar un ambiente académico más inclusivo, innovador y ético (Córdoba et al., 2021).

- Evaluación de impacto. Al evaluar impacto se valora que la investigación tenga un efecto tangible en la sociedad. En las instituciones dominicanas el impacto se mide principalmente por el número de personas beneficiadas o por la contribución de los proyectos a los Objetivos de Desarrollo Sostenible. La influencia de la investigación en políticas públicas es escasamente considerada como indicador de impacto relevante. Tampoco se están utilizando las altmetrics para evaluar el impacto social de la investigación. En algunas instituciones ni siquiera se realiza evaluación de impacto. Se reconoce que medir el impacto social de la investigación de manera precisa y cuantificable es un reto, ya que muchos de los efectos sociales son cualitativos y a largo plazo. Se plantea también la necesidad de que se definan procedimientos claros y estandarizados y que el sistema nacional de indicadores combine indicadores cualitativos y cuantitativos para evaluar esta dimensión (FOLEC/CLACSO, 2022).

- Colaboración científica. La evaluación de la colaboración científica nacional e intersectorial tiene baja prioridad, siendo que un tercio de las instituciones no la evalúa. La colaboración científica internacional se considera aún menos importante, ya que casi la mitad de las instituciones no la evalúan. Esto es relevante porque la colaboración científica internacional fortalece la investigación al facilitar el intercambio de recursos y conocimientos, ampliar el impacto global de las investigaciones y promover el desarrollo de redes de investigación (Fortunato et al., 2018).

- Ciencia abierta. Menos de la mitad de las instituciones tiene una política explícita de ciencia abierta. Aunque la gran mayoría considera importante y valora la publicación en acceso abierto, no muchos están de acuerdo en compartir abiertamente los datos de investigación para que se reutilicen. Superar estas barreras requiere abordajes que enfaticen la importancia de la transparencia, la colaboración y el beneficio público de compartir datos de investigación, así como políticas claras y apoyo institucional para la gestión adecuada de datos (Data sharing and the future of science, 2018).

- Enfoque de género en la evaluación de la investigación. La integración del enfoque de género en la evaluación del desempeño de los investigadores y en la calidad de la investigación se percibe como moderadamente importante. Los actores del sistema demandan mayor claridad sobre cómo integrar este enfoque en el sistema de evaluación, especialmente en cuanto a los beneficios que puede aportar a las investigadoras (Bührer et al., 2020; Zhang et al., 2021). Los actores del sistema requieren formación sobre las barreras sistémicas que enfrentan las mujeres en la academia y, por consecuente, como los sistemas de evaluación pueden profundizar la inequidad. Para lograr las metas de ciencia inclusiva que valoran los gestores del sistema, estas formaciones y la inclusión de indicadores de género en el sistema nacional son necesarios.

- Evaluación del desempeño en innovación. Muy pocas instituciones evalúan los resultados de actividades de innovación tecnológica, ya que no implementan proyectos de este tipo regularmente. En aquellas instituciones donde sí se lleva a cabo esta evaluación, los indicadores principales incluyen contratos de I+D, consultorías y patentes nacionales. Sin embargo, no se le da mucha importancia al registro de patentes en bases de datos internacionales. El registro de patentes es fundamental para establecer indicadores de competitividad y capacidad tecnológica dentro de las instituciones educativas (Van Raan, 2017). Es además importante destacar que hay escasa mención o valoración de la innovación social por parte de los integrantes del sistema.

- Malas prácticas en procesos de evaluación. Se considera que debe evitarse: la falta de transparencia en políticas y procedimientos; perder de vista la continuidad de líneas y programas de investigación; emplear evaluadores no expertos; utilizar datos no contrastados o depurados; priorizar el volumen sobre la calidad; no emplear indicadores cualitativos; el uso indiscriminado de criterios de rankings internacionales, como sobrevalorar las publicaciones en revistas Q1 y subestimar las publicaciones en revistas nacionales. Asimismo, se plantea que al evaluar se deben considerar las diferencias entre campos de investigación.

- Necesidad de cambio. Hay buena disposición para que se produzcan cambios en los procesos de evaluación. Para mejorar la evaluación, se propone: contar con sistemas de evaluación de proyectos y de categorización de los investigadores más transparentes; implementar un sistema nacional de indicadores con métodos e instrumentos estandarizados, con datos públicos y dinámicos, extraídos preferiblemente de fuentes internacionales; evaluar el impacto social y diferenciar la evaluación según las áreas del conocimiento; considerar métricas cualitativas y cuantitativas; y, en general, fomentar evaluaciones que promuevan el avance de los investigadores, de las instituciones y de la sociedad.

Consideraciones finales

Los resultados de este estudio subrayan la necesidad de una revisión sistemática de los procesos de evaluación de la investigación en las instituciones dominicanas, no solo para mejorar su efectividad, sino también para desarrollar capacidades institucionales de articulación y respuesta a la normatividad que acompañará la implementación del Sistema Nacional de Indicadores de Ciencia y Tecnología.

Muchas instituciones carecen de las competencias y estructuras adecuadas para llevar a cabo evaluaciones efectivas de su actividad investigadora. Las limitaciones principales están relacionadas con la falta de conocimientos y experiencias, así como con la disponibilidad de sistemas efectivos para recopilar datos de calidad y gestionar información relevante para la evaluación. Además, se requiere un compromiso institucional con la evaluación para promover la excelencia y el impacto social de la investigación, fomentando la participación de diversos actores en este proceso, incluyendo investigadores, personal administrativo y beneficiarios.

En el ámbito regional y mundial se plantea la necesidad imperativa de transformar los sistemas de evaluación científica para potenciar su capacidad de orientar las agendas de investigación hacia el desarrollo inclusivo y sostenible, así como hacia la generación de conocimientos con relevancia social y alto potencial de aplicación. Se espera que en la República Dominicana se inicie la discusión y la reflexión sobre estos temas cruciales.

Financiamiento

Este estudio fue financiado por el Fondo Nacional de Innovación y Desarrollo Científico y Tecnológico (FONDOCYT) administrado por el Ministerio de Educación Superior, Ciencia y Tecnología de la República Dominicana, como una actividad del proyecto No. FONDOCYT-2023-2-412-0510.

Referencias

Bührer, S., Kalpazidou Schmidt, E., Palmén, R. y Reidl, S. (2020). Evaluating gender equality effects in research and innovation systems. Scientometrics, 125, 1459-1475. https://doi.org/10.1007/s11192-020-03596-1

Córdoba, L., Rovelli, L. y Vommaro, A. (eds.) (2021). Política, gestión y evaluación de la investigación y la vinculación en América Latina y el Caribe. Buenos Aires: CLACSO. https://biblioteca-repositorio.clacso.edu.ar/handle/CLACSO/16778

Daraio, C. y Glänzel, W. (eds.) (2020). Evaluative Informetrics: The art of metrics-based research assessment. Springer, Cham. https://doi.org/10.1007/978-3-030-47665-6_18

Data sharing and the future of science (2018). Nature Communications, 9, 2817. https://doi.org/10.1038/s41467-018-05227-z

de Rijcke, S., Cosentino, C., Crewe, R., D’Ippoliti, C., Motala-Timol, S., Binti A Rahman, N., Rovelli, L., Vaux, D. y Yupeng, Y. (2023). The future of research evaluation: a synthesis of current debates and developments. Global Young Academy (GYA), InterAcademy Partnership (IAP), International Science Council (ISC). https://doi.org/10.24948/2023.06

de Rijcke, S., Wouters, P. F., Rushforth, A. D., Franssen, T. P. y Hammarfelt, B. (2016). Evaluation practices and effects of indicator use—a literature review. Research evaluation, 25(2), 161-169. http://dx.doi.org/10.1093/reseval/rvv038

Declaración de Barcelona sobre Información de Investigación Abierta (Barcelona Declaration on Open Research Information) (2024). Recuperado de https://barcelona-declaration.org/ [23 de agosto de 2024].

Declaración de San Francisco sobre la Evaluación de la Investigación (2012). Recuperado de https://sfdora.org/read/ [14 de mayo de 2024].

European Commission, Directorate-General for Research and Innovation (2021). Towards a reform of the research assessment system: scoping report. Publications Office. https://data.europa.eu/doi/10.2777/707440

Foro Latinoamericano sobre Evaluación Científica (FOLEC/CLACSO) (2020a). Para una transformación de la evaluación de la ciencia en América Latina y el Caribe: Diagnóstico y propuestas para una iniciativa regional. Consejo Latinoamericano de Ciencias Sociales (CLACSO). https://biblioteca-repositorio.clacso.edu.ar/handle/CLACSO/3349

Foro Latinoamericano sobre Evaluación Científica (FOLEC/CLACSO) (2020b). Para una transformación de la evaluación de la ciencia en América Latina y el Caribe: Evaluando la evaluación de la producción científica. Consejo Latinoamericano de Ciencias Sociales (CLACSO). https://biblioteca-repositorio.clacso.edu.ar/handle/CLACSO/3350

Foro Latinoamericano sobre Evaluación Científica (FOLEC/CLACSO) (2022). Una nueva evaluación académica y científica para una ciencia con relevancia social en América Latina y el Caribe. Ciudad de México: Consejo Latinoamericano de Ciencias Sociales (CLACSO). https://biblioteca-repositorio.clacso.edu.ar/handle/CLACSO/169563

Fortunato, S., Bergstrom, C. T., Börner, K., Evans, J. A., Helbing, D., Milojević, S., Petersen, A. M., Radicchi, F., Sinatra, R., Uzzi, B. Vespignani, A., Waltman, L., Wang, D. y Barabási, A. L.. (2018). Science of science. Science, 359(6379), eaao0185. https://doi.org/10.1126%2Fscience.aao0185

Glänzel, W., Moed, H. F., Schmoch, U. y Thelwall, M. (Eds.). (2019). Springer handbook of science and technology indicators. Dordrecht: Springer. https://doi.org/10.1007/978-3-030-02511-3

Helsinki Initiative on Multilingualism in Scholarly Communication (2019). Helsinki: Federation of Finnish Learned Societies, Committee for Public Information, Finnish Association for Scholarly Publishing, Universities Norway & European Network for Research Evaluation in the Social Sciences and the Humanities. https://doi.org/10.6084/m9.figshare.7887059

Hicks, D., Wouters, P., Waltman, L., de Rijcke, S. y Rafols, I. (2015). Bibliometrics: The Leiden manifesto for research metrics. Nature, 520, 429–431. https://dx.doi.org/10.1038/520429a

Invernizzi, N. (2022). Los sistemas de evaluación como conformadores de agendas científicas. Ciencia, tecnología y política, 5(9), 080-080. https://doi.org/10.24215/26183188e080

Llamada de Jussieu para la Ciencia Abierta y la Bibliodiversidad (2016). Recuperado de https://jussieucall.org/llamada-de-jussieu/ [14 de mayo de 2024]

Maltseva, D. y Batagelj, V. (2020). iMetrics: the development of the discipline with many names. Scientometrics, 125, 313–359 (2020). https://doi.org/10.1007/s11192-020-03604-4

Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura (2021). Recomendación de la UNESCO sobre la ciencia abierta. Documento No. SC-PCB-SPP/2021/OS/UROS. https://doi.org/10.54677/YDOG4702

Red Iberoamericana de Indicadores de Ciencia y Tecnología (RICYT) (2022). Agenda 2022. Temas de indicadores de ciencia y tecnología. Buenos Aires: Observatorio Iberoamericano de la Ciencia, la Tecnología y la Sociedad (OCTS) de la Organización de Estados Iberoamericanos (OEI). https://www.ricyt.org/2023/01/agenda-2022/

Rovelli, L. (2023). Evaluación responsable y ciencia abierta: agenda de reformas. Integración y Conocimiento, 12(2), 11–27. https://doi.org/10.61203/2347-0658.v12.n2.42029

Sivertsen, G. (2019). Developing Current Research Information Systems (CRIS) as data sources for studies of research. En Springer Handbook of Science and Technology Indicators (pp. 667-683). https://dx.doi.org/10.1007/978-3-030-02511-3_25

van Raan, A. F. (2017). Patent citations analysis and its value in research evaluation: A review and a new approach to map technology-relevant research. Journal of Data and Information Science, 2(1), 13-50. https://doi.org/10.1515/jdis-2017-0002

Zhang, L., Sivertsen, G., Du, H., Huang, Y. y Glänzel, W. (2021). Gender differences in the aims and impacts of research. Scientometrics, 126, 8861-8886. https://doi.org/10.1007/s11192-021-04171-y

Anexo

Tablas y gráficos con todos los datos procesados del estudio

Respuestas y valoraciones de los gestores e investigadores sobre las dimensiones analizadas. Nota: en la escala de 0-5, 0 es el grado más bajo y 5 es el grado más alto.

¿Su organización realiza procesos de monitoreo y evaluación de sus propias actividades y resultados de investigación e innovación?

|

|||||||

¿La evaluación de la investigación en su organización se realiza de manera sistemática y periódica?

|

|||||||

Indique el grado de sistematización del proceso de evaluación de la investigación en su organización. |

|||||||

|

0 |

1 |

2 |

3 |

4 |

5 |

Puntuación media |

Gestores |

0% |

17% |

42% |

25% |

17% |

0% |

2.4 |

Investigadores |

15% |

0% |

15% |

15% |

46% |

8% |

3.0 |

Todos |

8% |

8% |

28% |

20% |

32% |

4% |

2.7 |

¿Cuáles son los objetivos de la evaluación de la investigación que se hace en su organización?

|

|||||||

¿Qué se evalúa? Indique únicamente las dimensiones o aspectos que efectivamente se evalúan.

|

|||||||

¿Qué tan importante es demostrar a la sociedad el rendimiento y el impacto de la investigación que se lleva a cabo en su organización? |

|||||||

|

0 |

1 |

2 |

3 |

4 |

5 |

Puntuación media |

Gestores |

0% |

0% |

8% |

8% |

17% |

67% |

4.4 |

Investigadores |

0% |

0% |

0% |

8% |

15% |

77% |

4.7 |

Todos |

0% |

0% |

4% |

8% |

16% |

72% |

4.6 |

¿Por qué es importante demostrar un buen desempeño científico? Indique los tres motivos que considere más importantes.

|

|||||||

¿Qué importancia tiene la construcción sistemática y periódica de indicadores cienciométricos con fines evaluativos? |

|||||||

|

0 |

1 |

2 |

3 |

4 |

5 |

Puntuación media |

Gestores |

0% |

0% |

0% |

17% |

17% |

67% |

4.5 |

Investigadores |

0% |

0% |

8% |

8% |

15% |

69% |

4.5 |

Todos |

0% |

0% |

4% |

12% |

16% |

68% |

4.5 |

¿Cuenta su organización con una base de datos institucional o un sistema de información de la investigación (CRIS, RIS) en implementación actualmente?

|

|||||||

¿Este sistema de información, se consulta de forma abierta o cerrada?

|

|||||||

Indique la cobertura del sistema o base de datos.

|

|||||||

Si no hay un sistema o una base de datos institucional, ¿cómo se registran las actividades y los productos de investigación?

|

|||||||

¿Cuáles fuentes de datos externas utiliza para la generación de los indicadores?

|

|||||||

¿Cuáles fuentes de datos desaprueba que se utilicen para la generación de indicadores cienciométricos comparables entre distintas instituciones o países?

|

|||||||

¿Cuáles son las principales limitaciones o desafíos para implementar un sistema de indicadores?

|

|||||||

INDICADORES DE CALIDAD: Valore cada uno de estos aspectos según considere su relevancia o idoneidad como indicadores de calidad de la investigación. |

|||||||

|

Muy importante |

Puntuación media (0-5) |

|||||

Rigor del método científico |

76% |

4.8 |

|||||

Ética de la investigación |

80% |

4.7 |

|||||

Revisión de pares |

80% |

4.7 |

|||||

Efectos demostrables de la investigación |

64% |

4.5 |

|||||

Núrnero de citas |

52% |

4.3 |

|||||

Impacto social o económico |

56% |

4.2 |

|||||

Influencia en politicas públicas |

40% |

4.2 |

|||||

Factor de impacto o cuartil de la revista |

40% |

4.1 |

|||||

Otros indicadores de calidad de la investigación no mencionado antes. |

|||||||

|

|||||||

INDICADORES DE IMPACTO: Valore la relevancia e idoneidad de cada uno de estos aspectos como indicadores de impacto de la investigación. |

|||||||

|

Muy importante |

Puntuacion media (0-5) |

|||||

Efectos demostrables de la investigacion |

64% |

4.5 |

|||||

Impacto social o economico |

56% |

4.2 |

|||||

Influencia en politicas publicas |

40% |

4.2 |

|||||

Menciones en redes sociales academicas |

24% |

3.4 |

|||||

¿Está de acuerdo en que el número o proporción de investigadores miembros de la Carrera Nacional de Investigadores en Ciencia y Tecnología (CNI-MESCYT) es una medida de reconocimiento a la calidad de la actividad investigadora de su organización? |

|||||||

|

0 |

1 |

2 |

3 |

4 |

5 |

Puntuación media |

Gestores |

0% |

8% |

17% |

33% |

33% |

8% |

3.2 |

Investigadores |

15% |

0% |

8% |

31% |

15% |

31% |

3.2 |

Todos |

8% |

4% |

12% |

32% |

24% |

20% |

3.2 |

¿Está de acuerdo en que el número o la proporción de los proyectos que son aprobados para financiamiento del FONDOCYT son medidas de la capacidad competitiva de su organización en materia de CyT? |

|||||||

|

0 |

1 |

2 |

3 |

4 |

5 |

Puntuación media |

Gestores |

8% |

25% |

33% |

8% |

25% |

0% |

2.2 |

Investigadores |

8% |

8% |

15% |

31% |

31% |

8% |

2.9 |

Todos |

8% |

16% |

24% |

20% |

28% |

4% |

2.6 |

¿Cómo se mide el volumen de la actividad y de la producción científica en su organización?

|

|||||||

¿Cuáles productos se toman en cuenta en su organización para medir los resultados de las actividades de innovación?

|

|||||||

¿Cómo se mide la calidad de la investigación que se lleva a cabo en su organización?

|

|||||||

¿Cómo se mide el impacto de la investigación que se lleva a cabo en su organización?

|

|||||||

¿Cómo se mide el grado de la colaboración científica nacional e intersectorial?

|

|||||||

¿Cómo se mide el grado de la colaboración científica internacional?

|

|||||||

¿Qué tan importante considera el liderazgo en los grupos internacionales de investigación? |

|||||||

|

0 |

1 |

2 |

3 |

4 |

5 |

Puntuación media |

Gestores |

8% |

0% |

0% |

0% |

42% |

50% |

4.2 |

Investigadores |

0% |

8% |

8% |

8% |

0% |

77% |

4.3 |

Todos |

4% |

4% |

4% |

4% |

20% |

64% |

4.2 |

¿Cómo propone usted que se puede operacionalizar la evaluación de impacto social de la investigación?

|

|||||||

¿Tiene su organización una política de ciencia abierta explícita y estrategias para contribuir al acceso abierto a la producción científica?

|

|||||||

¿Considera importante la publicación de artículos científicos en acceso abierto? |

|||||||

|

0 |

1 |

2 |

3 |

4 |

5 |

Puntuación media |

Gestores |

0% |

0% |

0% |

0% |

0% |

100% |

5.0 |

Investigadores |

0% |

0% |

0% |

0% |

8% |

92% |

4.9 |

Todos |

0% |

0% |

0% |

0% |

4% |

96% |

5.0 |

¿Considera beneficioso y está de acuerdo en compartir abiertamente los datos de investigación y permitir que se reutilicen? |

|||||||

|

0 |

1 |

2 |

3 |

4 |

5 |

Puntuación media |

Gestores |

0% |

0% |

0% |

8% |

25% |

67% |

4.6 |

Investigadores |

0% |

0% |

0% |

23% |

0% |

77% |

4.5 |

Todos |

0% |

0% |

0% |

16% |

12% |

72% |

4.6 |

¿Considera importante que se integre el enfoque de género en los procesos de evaluación del desempeño del personal investigador? |

|||||||

|

0 |

1 |

2 |

3 |

4 |

5 |

Puntuación media |

Gestores |

8% |

0% |

0% |

17% |

17% |

58% |

4.1 |

Investigadores |

15% |

0% |

15% |

23% |

15% |

31% |

3.2 |

Todos |

12% |

0% |

8% |

20% |

16% |

44% |

3.6 |

¿Considera importante integrar la dimensión de género para mejorar la calidad de la investigación? |

|||||||

|

0 |

1 |

2 |

3 |

4 |

5 |

Puntuación media |

Gestores |

8% |

0% |

0% |

17% |

25% |

50% |

4.0 |

Investigadores |

15% |

0% |

15% |

31% |

15% |

23% |

3.0 |

Todos |

12% |

0% |

8% |

24% |

20% |

36% |

3.5 |

¿Considera que se deben promover y producir cambios en la forma en la que se evalúa el desempeño y el impacto de la ciencia y la tecnología en su organización y en el ecosistema nacional y mundial?

|

|||||||

¿Considera que se deben promover y producir cambios en la forma en la que se evalúa el desempeño y el impacto de la ciencia y la tecnología en su organización y en el ecosistema nacional y mundial?

|

|||||||

¿Qué cambio importante le gustaría ver que se produjera en la forma en que la calidad y el impacto de la investigación son medidos y evaluados?

|

|||||||

Fuente: Elaboración propia basada en los resultados de la investigación.

_______________________________

1 Giovanna Riggio-Olivares: conceptualización, investigación, curación de datos, análisis formal, redacción – borrador original. Aída Mencía-Ripley: conceptualización, investigación, curación de datos, análisis formal, redacción – borrador original. Ramón I. Rosario-Díaz: asistente de investigación, curación de datos.